Posted by Tiago Beulke on julho 29, 2014

Quem não está muito familiarizado com os componentes de um computador ou está montando a sua máquina pela primeira vez geralmente não presta muita atenção na fonte de alimentação. Alguns até sabem que ela precisa ter “potência real”, mas geralmente esse dispositivo acaba sendo negligenciado.

Mas o que significa uma fonte ter potência real? Significa que as outras são mentirosas? Na verdade esse termo não existe, pois ele foi criado pelo comércio brasileiro para diferenciar fontes de alimentação genéricas de fontes mais robustas, com qualidade superior. Esse tipo de classificação começou a surgir com as placas de vídeo mais poderosas.

O problema é que mesmo muitas dessas fontes que prometem oferecer “potência real” nem sempre são capazes de cumprir essa tarefa. Ou até conseguem, mas sem nenhum cuidado ou critério de segurança.

Geralmente, quem vai montar um computador tem um orçamento limitado e prefere investir em componentes que vão trazer um aumento mais perceptível no desempenho, como placa de vídeo, processador ou memória. A fonte de alimentação geralmente fica em segundo plano, pois as pessoas escolhem aquela que possa fazer a máquina funcionar, mas que custe o mínimo possível.

Muitas empresas montam computadores assim, pois é um dos itens que podem permitir um aumento considerável da margem de lucro; afinal de contas, ou o computador liga ou não liga. Se ele está funcionando, aparentemente está tudo certo. O cliente que se vire depois se quiser instalar um periférico extra na máquina.

O problema em utilizar fontes de alimentação de baixa qualidade

O problema é que “ligar a máquina” não é tudo que o computador precisa. É possível fazer uma simples analogia com o corpo humano para entender isso.

Imagine duas pessoas. A primeira só se alimenta com doces, fast food e alimentos sem nutrientes. A segunda tem uma alimentação bastante equilibrada que inclui frutas, vegetais, proteínas e fibras, todos na dose correta. Qual dessas duas pessoas você acha que seria mais saudável e teria mais disposição? Obviamente que é a segunda.

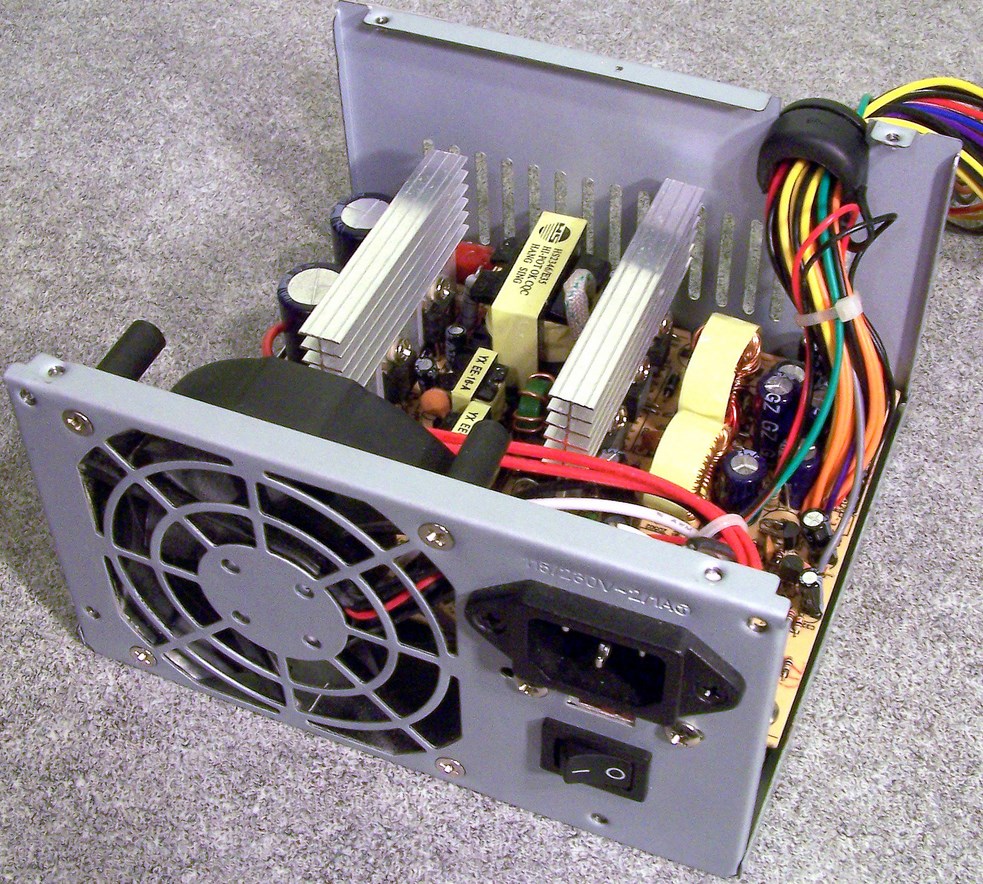

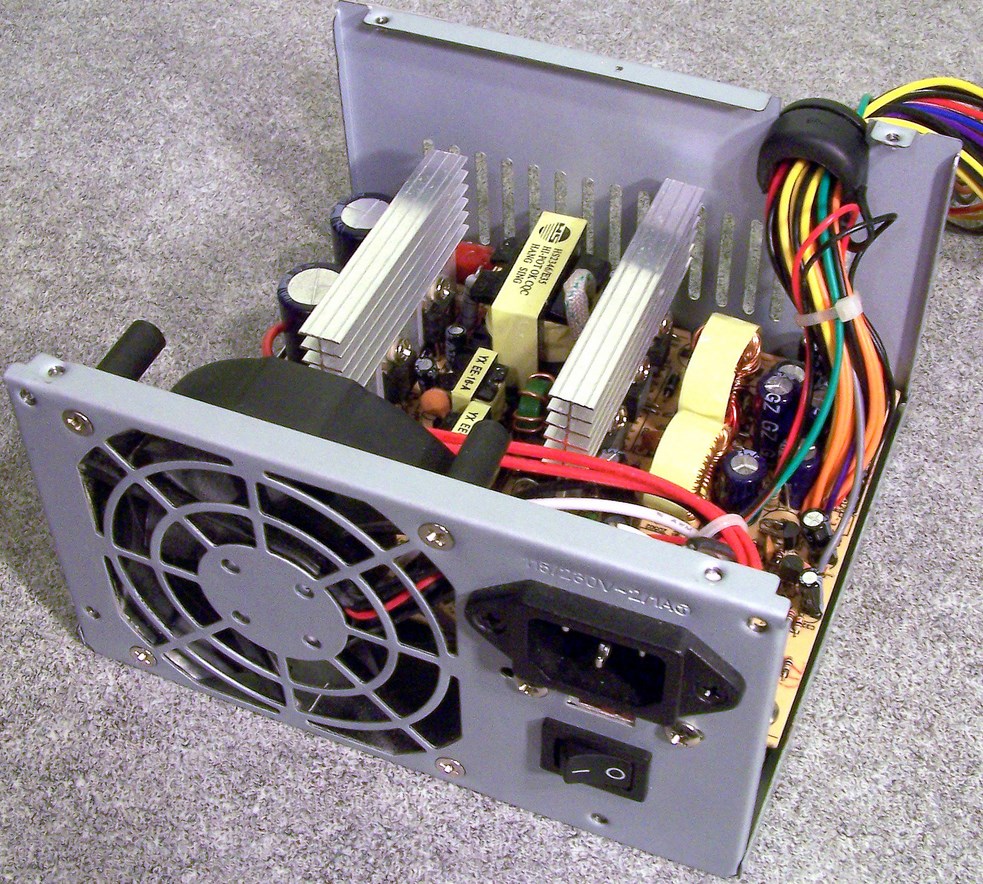

A maioria das fontes genéricas tem um visual parecido com esse.

Com o seu computador é a mesma coisa: se você o alimenta de forma errada, ele vai funcionar mal. Assim como uma pessoa que não tem uma alimentação saudável, os componentes eletrônicos não funcionam muito bem se a energia elétrica não é suficiente ou é fornecida de maneira errada.

Diferenças entre uma fonte e uma “bomba” de alimentação

Para entender a diferença entre uma fonte ruim e uma fonte de boa qualidade, é preciso entender o princípio de funcionamento desses equipamentos. A sua tarefa principal é converter a energia que vem da rede elétrica, geralmente 110/220 V 60 Hz para os 12/3,3/5 V normalmente utilizados pelos componentes eletrônicos. A fonte também converte a corrente alternada (AC) proveniente da tomada para corrente direta (DC).

Converter diretamente a energia de AC para DC exigiria componentes muito grandes, por isso a energia é convertida para AC de alta frequência, para que então ela possa ser transformada em energia DC.

Fontes de boa qualidade possuem mais componentes em seu interior.

Depois dessa transformação, a energia ainda está “suja” e precisa ser retificada para não danificar os componentes do computador, e é aí que entra uma série de filtros diferentes.

O principal é o PFC ou “Fator de Correção de Energia”, que é responsável por diminuir o problema com a energia reativa que é gerada na entrada de energia da fonte. Existem dois tipos de PFC: ativo e passivo. O passivo é composto apenas por componentes que filtram a energia que sai do transformador, enquanto o ativo possui um circuito próprio desenvolvido especificamente para retificar a energia em diversos passos.

Depois disso, a energia de entrada passa pelos reguladores que a transformam nos 12/3,3/5 V utilizados pela máquina. Depois a energia de saída é filtrada para ter certeza de que as tensões sejam entregues de forma correta para os componentes do computador.

É justamente aí que entra um dos maiores problemas das fontes genéricas. Para economizar, os fabricantes utilizam componentes de baixa qualidade. Com isso, existem perdas de energia de uma fase para outra e essa perda geralmente causa oscilação de tensões, além, é claro, de gerar calor desnecessariamente.

Para piorar, algumas fontes não possuem todos os componentes necessários (novamente, para cortar despesas) para filtrar a energia e o que é entregue para o computador não é adequado para fazer os circuitos funcionarem como se deve.

O sistema de refrigeração também é um ponto muito importante na hora da compra. Enquanto fontes de boa qualidade possuem coolers grandes e com garantia de bom funcionamento, fontes mais simples trazem coolers ruins, barulhentos e ineficientes; o que não deixa de ser uma ironia, já que essas fontes costumam aquecer mais que componentes de qualidade.

O que uma fonte ruim pode fazer com a máquina

Existe uma série de problemas decorrentes de uma alimentação inadequada. Um deles é a oscilação constante no fornecimento de energia. Isso porque os componentes são desenvolvidos para trabalhar com um valor fixo, por exemplo, 12 V. Se a fonte é ruim, ela pode fornecer 11, 13 V ou até mesmo valores diferentes disso.

O que acontece é que o componente alimentado precisa forçar a retificação de energia, “cansando” mais e gerando mais calor. Isso é extremamente prejudicial para qualquer eletrônico, pois sua vida útil diminui consideravelmente.

Você já deve ter ouvido falar nas linhas de energia da fonte. Cada uma dessas trilhas é uma das origens principais das tensões, sendo que as três principais são 12/3,3/5 V. Enquanto as linhas 3,3 e 5 V geralmente são utilizadas para alimentar periféricos como discos rígidos, as linhas 12 V alimentam o processador e as placas de vídeo. Em algumas fontes, a linha 12 V é dividida, ou seja, existe mais de uma. Isso serve basicamente para proteger o computador de falhas. Se um componente puxar mais energia do que essa linha pode fornecer, a fonte desliga para preservar o hardware.

Em fontes de qualidade que possuem apenas uma linha 12 V, ela geralmente é robusta, pronta para fornecer toda a potência que a máquina precisa. Isso pode ser visto na Cooler Master V1200: ela oferece apenas uma linha 12 V, mas capaz de trabalhar com uma corrente de até 100 A (12 V x 100 A = 1.200 W).

Já no caso de fontes de baixa qualidade, não é possível saber quanta corrente a linha 12 V pode fornecer. Possivelmente será abaixo do que a máquina precisa para funcionar, principalmente se você tiver uma placa de vídeo dedicada instalada na máquina.

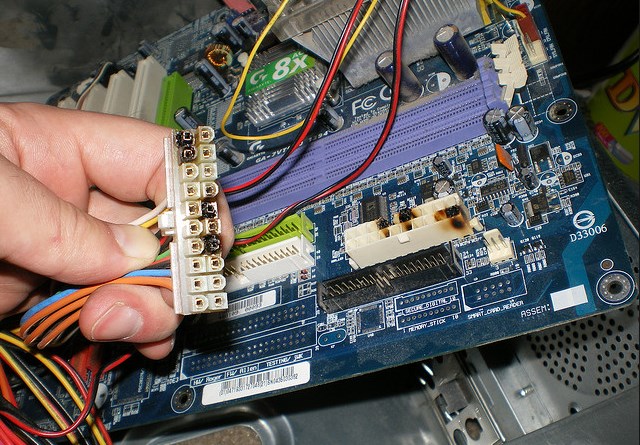

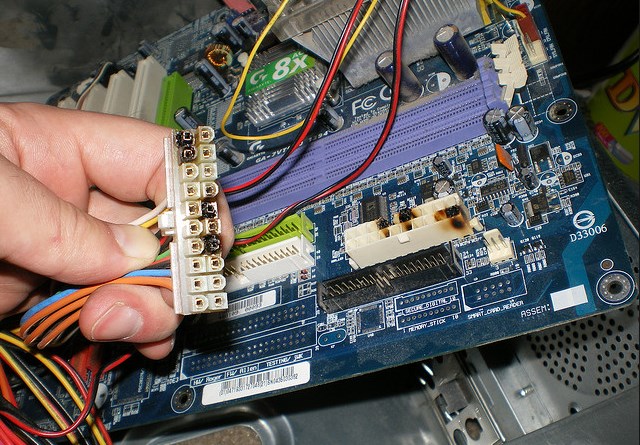

Economizar na compra da fonte pode render em uma placa-mãe inutilizada.

Economizar na compra da fonte pode render em uma placa-mãe inutilizada.

O que acontece é que, quando a máquina estiver em plena capacidade, ela vai puxar mais energia da fonte. Como não há energia suficiente, os fios vão aquecer além do limite. Por sorte a fonte vai “desarmar” e nada será danificado.

Contudo, a tendência é que você tente ligar a máquina novamente depois de ela desligar. E é aí que o conector ATX da fonte e o conector ATX da placa-mãe vão derreter e virar uma peça só. Se a máquina não desligar sozinha e você não sentir cheiro de queimado, é bastante provável que ela pegue fogo e você perca a maioria dos componentes internos do seu PC.

Outros componentes também sofrem com a instabilidade no fornecimento de energia. Uma placa de vídeo pode ter seus elementos danificados; um HD pode falhar durante o funcionamento e resultar em bad blocks; um processador pode aquecer mais do que o normal e queimar.

Isso tudo sem falar na dor de cabeça que é ver a máquina falhando, mais lenta ou desligando sozinha esporadicamente. Já pensou investir todas as suas economias em um PC que não funciona como o prometido?

Eficiência energética: não jogue dinheiro fora

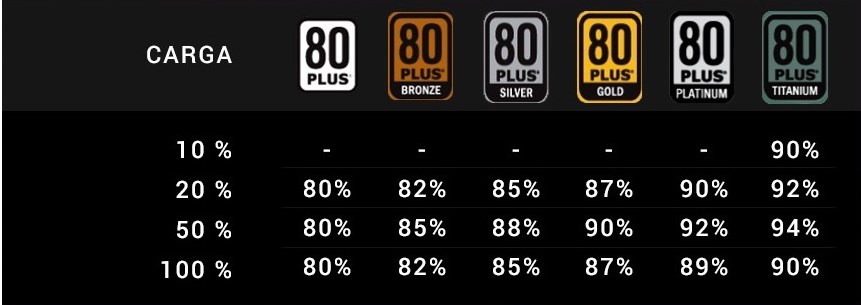

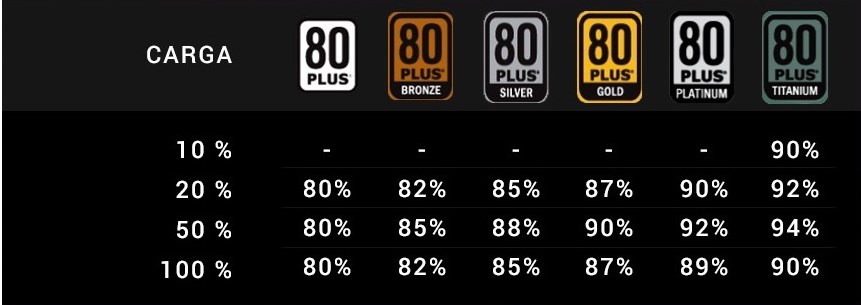

Qualquer tipo de transformação de energia gera perda e essa perda é transformada em calor. Quanto mais calor, mais perigo de acidente e mais dinheiro jogado fora. As fontes de alimentação de qualidade possuem eficiência garantida pelo selo 80 Plus.

Entender o que significa a eficiência da fonte é simples: no caso de uma fonte com eficiência de 90%, apenas 10% será desperdiçado em forma de calor, ou seja: se a sua máquina precisa de 500 W para funcionar, a fonte vai puxar da tomada 550 W. Destes, cerca de 50 W serão transformados em calor.

Já as fontes de alimentação genéricas apresentam taxas de eficiência muito baixas, algumas na casa de 70% ou até 60%. Isso significa que se uma fonte for de 500 W e tiver eficiência de 70%, cerca de 30% da energia será desperdiçada em forma de calor, ou seja, em vez de 500 W ela vai puxar da tomada 650 W. Isso significa que você estará literalmente queimando dinheiro.

…..

A médio e longo prazo, utilizar uma fonte de alimentação vagabunda vai acabar custando muito mais caro, pois o dinheiro que você economizou na compra dela precisará ser gasto na compra de novos componentes, que estarão danificados por culpa da alimentação inadequada que você deu ao seu computador.

Na hora de montar uma máquina personalizada, nunca deixe de calcular o preço da fonte de alimentação.

Fuja de fontes ditas “watts real” ou “potência real”. Antes da compra, escolha um modelo preferencialmente de marca conhecida e faça uma pesquisa para saber se o componente é mesmo de qualidade.